Nắm bắt cơ hội từ Luật Trí tuệ nhân tạo mới ban hành

Luật Trí tuệ nhân tạo đầu tiên của Việt Nam được thông qua vào ngày 10/12/2025 và sẽ có hiệu lực từ 1/3/2026, đánh dấu cột mốc quan trọng trong chiến lược quản trị số và đổi mới sáng tạo của đất nước.

Tích hợp năng lượng hạt nhân vào lưới điện một cách an toàn

Luật Năng lượng nguyên tử (sửa đổi) mở ra cánh cửa cho các công nghệ hạt nhân tiên tiến, nhưng theo nhận định của các giảng viên RMIT, thành công sẽ phụ thuộc vào sự sẵn sàng của lưới điện, văn hóa an toàn và nguồn nhân lực có kỹ năng.

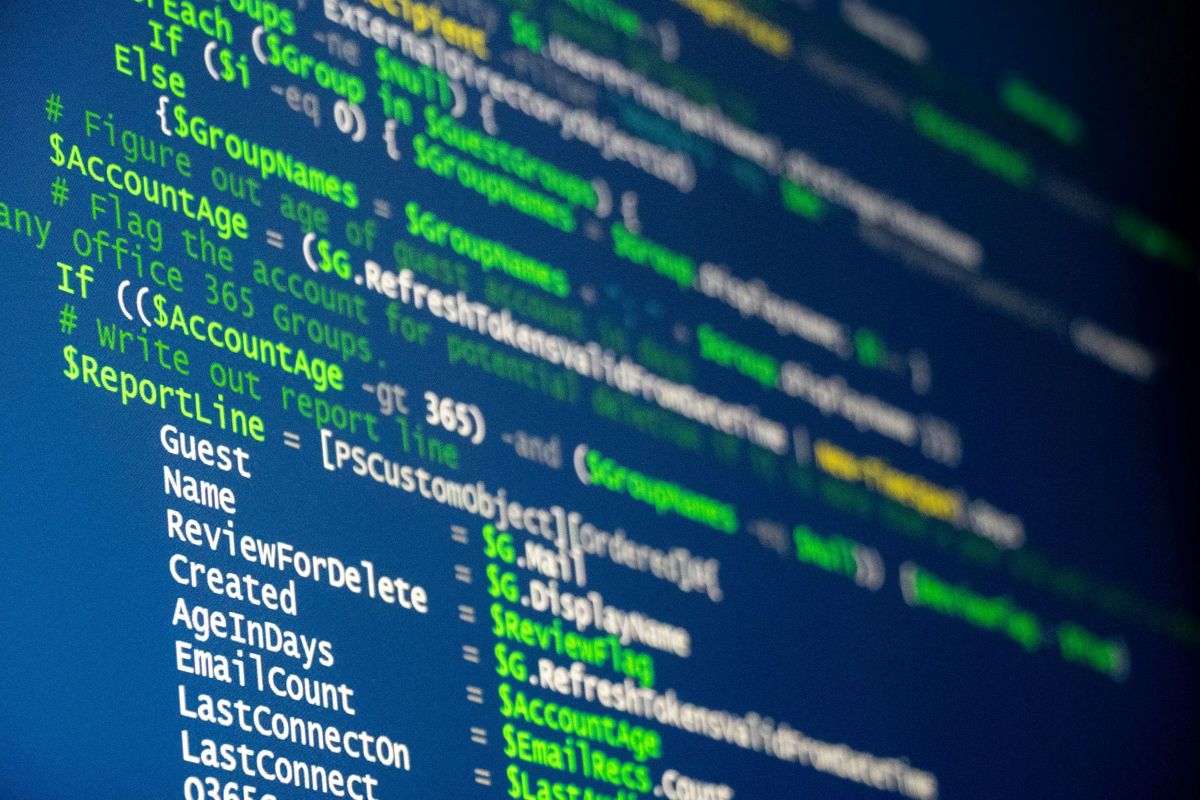

Chuyên gia RMIT cảnh báo nguy cơ an toàn thông tin và tâm lý từ nội dung thiếu kiểm chứng

Các chuyên gia về công nghệ thông tin, tâm lý học và truyền thông của Đại học RMIT Việt Nam chia sẻ góc nhìn về những rủi ro khi tiếp nhận và lan truyền thông tin chưa được kiểm chứng trên mạng.

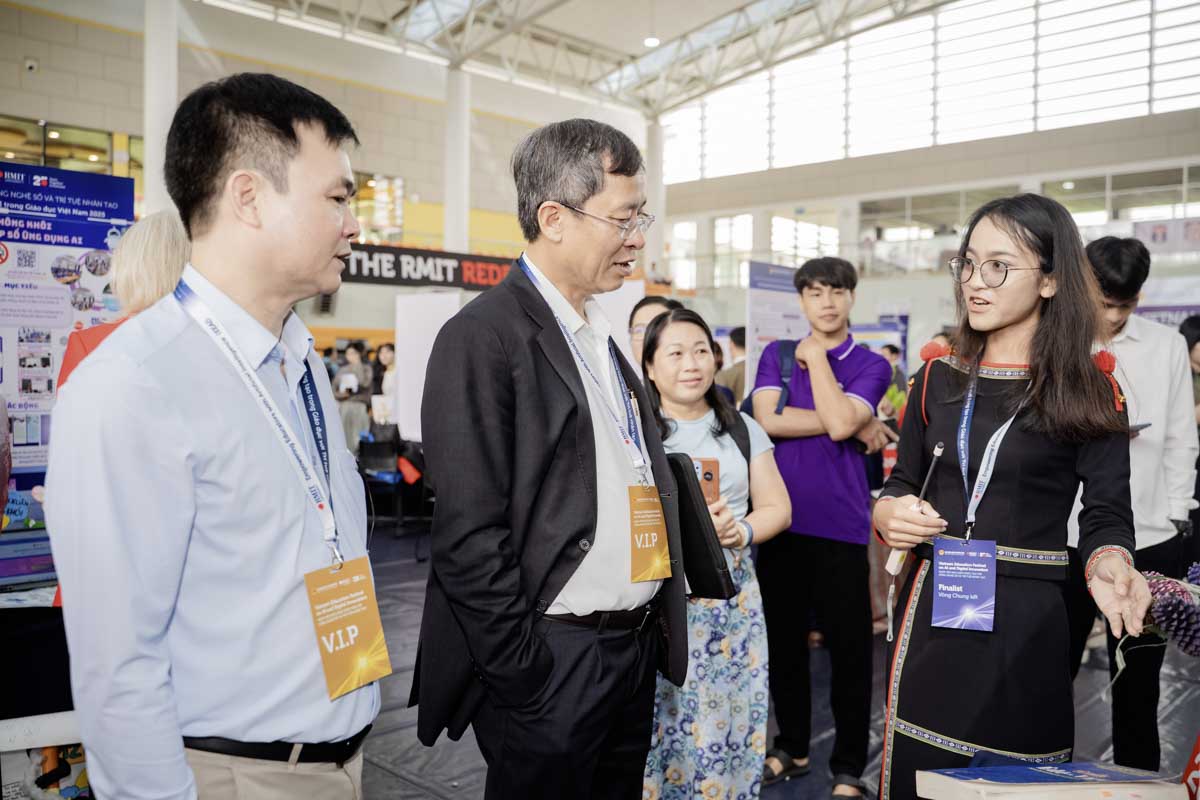

Ngày hội Nhà giáo sáng tạo với công nghệ số và AI tôn vinh nhiều sáng kiến ứng dụng AI trong giáo dục

Bộ Giáo dục và Đào tạo (GD&ĐT) phối hợp cùng Đại học RMIT Việt Nam đã tổ chức thành công "Ngày hội Nhà giáo sáng tạo với công nghệ số và trí tuệ nhân tạo 2025" nhằm tạo sân chơi giao lưu học hỏi cho đội ngũ nhà giáo trên cả nước.